Transformer 시리즈 (3) : Improving Language Understanding by Generative Pre-Training

현재, 우리는 GPT의 시대에 살고 있다고 해도 과언이 아닙니다. 2023년 말 gpt-3.5 기반의 Chatgpt가 세상에 등장하고 부터, 그 이전과 이후의 세상은 완전히 달라졌다고 생각합니다. 사람들의 업무 일부를 GPT가 대체하기 시작했고 그로 인해 생산성은 빠르게 올라갔습니다. 또한 GPT에 대항하기 위해 Claude, Perplexity 와 같은 서비스들이 출시되었습니다. 그리고 GPT를 활용한 다양한 서비스들이 속속 등장하고 있습니다. 현재 gpt-3.5 이후에 gpt-4. 4o, o1 등이 출시되었습니다. 그렇다면 gpt의 처음은 무엇이었을까요? Improving Language Understanding by Generative Pre-Training(2018)에서 제안한 모델이 GPT의 시작입니다. 사실 해당 paper에서 Generative Pre-Training라는 말만 사용하여 직접적으로 gpt라는 말이 직접적으로 등장하지는 않습니다. 이후 블로그 등을 통해 해당 모델을 gpt라고 명명했고, OpenAI에서는 이후 GPT-2를 공개하며 paper에서 "The architectures are summarized in Table 2. The smallest model is equivalent to the original GPT, and the second smallest equivalent to the largest model from BERT (Devlin et al., 2018)." 라는 문구를 통해 해당 모델의 이름을 GPT라고 명명했습니다. 그래서 현재는 OpenAI GPT 혹은 GPT-1 등으로 불립니다. 이제 GPT-1 논문에 대해서 살펴보면,

Natural language understanding comprises a wide range of diverse tasks such as textual entailment, question answering, semantic similarity assessment, and document classification. Although large unlabeled text corpora are abundant, labeled data for learning these specific tasks is scarce, making it challenging for discriminatively trained models to perform adequately. We demonstrate that large gains on these tasks can be realized by generative pre-training of a language model on a diverse corpus of unlabeled text, followed by discriminative fine-tuning on each specific task. In contrast to previous approaches, we make use of task-aware input transformations during fine-tuning to achieve effective transfer while requiring minimal changes to the model architecture. We demonstrate the effectiveness of our approach on a wide range of benchmarks for natural language understanding.

OpenAI에서 gpt-1을 공개하면서 Paper에 적은 Abstract인데요. 이를 요약하면 자연어 이해(Natural language understanding) 태스크는 너무 많은데, 각각 태스크에 대한 데이터는 너무 적으니 방대한 무라벨 텍스트로 생성형 사전 학습을 수행한 뒤, 각 과제에 맞춰 차별적 미세 조정(Discriminative Fine-tuning)을 적용하였더니 미세 조정 시 태스크에 맞는 입력 변환을 사용하며, 모델 구조의 큰 변경 없이도 효과적인 전이 성능을 얻었고 이를 평가하니 12개 과제 중 9개에서 기존 최고 성능을 뛰어넘음. 특히 상식 추론, 질의응답, 텍스트 추론 과제에서 큰 성능 개선을 보인다는 내용입니다.

그래서 해당 논문에서는 무라벨 텍스트를 활용하여 비지도 학습(unsupervised pre-training)으로 언어 모델링 목표를 사용해 신경망의 초기 파라미터 학습하고 사전학습된 모델을 각 대상 작업에 맞추어 지도 목표로 미세조정하는 지도 미세 조정(supervised fine-tuning) 과정을 매우 중요하게 다루고 있습니다. 또한 미세 조정 과정에서 순차적(traversal-style) 접근법을 통해 구조화된 텍스트를 하나의 연속 토큰 시퀀스로 처리, 최소한의 아키텍처 변경으로 효과적인 미세조정 달성하였다고 합니다. 이 때 모델의 아키텍쳐로 이 논문 기준으로 신기술인 Transformer를 적용하여 장기 의존성을 효과적으로 처리하고 순환 신경망보다 구조화된 메모리를 제공하는 효과를 가져왔다고 합니다.

이 논문은 어떻게 보면 현재 LLM을 비롯한 논문의 엄마 정도되는 것 같습니다. (전에 다루었던 Transformer는 할머니라고 하겠습니다.) 그렇기에 매우 중요한 논문이 아닐 수 없는데요. 이 논문에서 제시된 학습 프레임 워크는 아래와 같습니다. 계속해서 설명드렸듯이 2단계로 이루어져 있습니다.

1. 모델의 프레임워크

1) Unsupervised Pre-training

대규모 텍스트 코퍼스에서 언어 모델을 학습하여 좋은 초기 파라미터(Θ)를 얻는 것을 목표로 진행하는데, 주어진 토큰 시퀀스 U = {u_1, u_2, ...., u_n}에 대해서 아래와 같은 이전 개의 토큰을 바탕으로 다음 토큰의 확률을 예측하는 언어 모델링 목표를 최대화하는 것이 목표입니다.

모델의 아키텍쳐는 다층 Transformer 디코더(마스크드 셀프 어텐션, 포지션 임베딩 및 피드포워드 레이어 포함)를 사용하여 입력 토큰의 문맥 정보를 효과적으로 캡처하도록 구성되었습니다.

2) Supervised Fine-tuning

사전학습된 모델을 활용하여, 라벨이 있는 데이터를 대상으로 특정 판별 작업(discriminative task)에 맞게 파인튜닝하는 것이 목표인데요. 각 입력 시퀀스 x_1,…,x_m와 레이블 를 모델에 통과시켜 마지막 Transformer 블록의 활성화 를 얻은 후, 선형 출력 레이어를 통해 y를 예측하는데요. 즉, 아래와 같은 지도 목표를 최대화하는 것이 목표입니다.

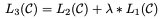

또한 보조 목표를 추가하는데 미세 조정시 언어 모델링 목표 였던 L_1을 보조 손실로 추가하여 (가중치를 적용) 일반화 성능을 향상하고 수렴속도를 개선하였다고 합니다.

2. . 실험 및 결과

1) Unsupervised Pre-training

BooksCorpus라는 데이터셋을 활용하여 비지도 학습을 진행했으며 이는 장기 의존성(long-range dependency) 학습에 유리하다고 합니다. 모델에 대한 더 자세한 사항은 아래와 같습니다.

- 12층의 디코더 전용 Transformer

- 768 차원의 상태, 12개의 어텐션 헤드, 피드포워드 네트워크의 내부 차원은 3072

- Adam 옵티마이저, 특정 학습률 스케줄(워밍업 후 코사인 스케줄) 적용

- Byte-Pair Encoding (BPE) 방식의 40,000 단위 어휘 사용

- Dropout, L2 정규화, GELU 활성화 함수 등 다양한 정규화 기법 적용

2) Supervised Fine-tuning

지도 미세조정의 경우, 여러개의 Task에 대해서 진행하였는데 모두 높은 성능을 달성하였다고 합니다.

- 자연어 추론 (Natural Language Inference, NLI)

- 데이터셋: SNLI, MNLI, QNLI, SciTail, RTE 등

- 결과: 대부분의 데이터셋에서 기존 최고 성능 대비 절대적 향상(예: MNLI에서 1.5%, SciTail에서 5%, QNLI에서 5.8% 등)을 달성

- 질문 응답 및 상식 추론

- 데이터셋: RACE, Story Cloze Test

- 결과: Story Cloze Test에서 최대 8.9%, RACE에서 5.7%의 향상

- 의미 유사성 (Semantic Similarity)

- 데이터셋: MRPC, Quora Question Pairs, STS Benchmark

- 결과: STS Benchmark에서 1점 이상 절대적 향상, QQP에서는 4.2% 정도의 큰 성능 향상

- 텍스트 분류 (Classification)

- 데이터셋: CoLA (문법 적합성 평가), SST-2 (감성 분석)

- 결과: CoLA에서는 이전 최고 결과(35.0)를 크게 뛰어넘어 45.4 기록, SST-2에서는 91.3%의 높은 정확도 달성

- 종합 성능:

- GLUE 벤치마크 전체 점수는 72.8로, 이전 최고 68.9를 뛰어넘음

- 전체 12개 평가 데이터셋 중 9개에서 새로운 최첨단(state-of-the-art) 성능을 달성함

이 논문은 GPT라는 이름을 세상에 내놓은 만큼 많은 의의가 있습니다.

두 단계 학습 전략 (비지도 사전학습 + 지도 미세조정)을 통해, 대규모 비라벨 데이터로부터 강력한 언어 표현을 학습하고 이를 다양한 NLP 작업에 효과적으로 전이함

Transformer 기반 아키텍처를 사용함으로써, LSTM 기반 모델보다 더 긴 범위의 언어 구조를 포착할 수 있어, 문장 간 관계나 긴 문맥 의존성을 효과적으로 처리

태스크별 입력 변환 기법을 통해, 구조화된 입력도 최소한의 아키텍처 변경으로 처리 가능

다양한 NLP 벤치마크에서 기존 방법 대비 의미 있는 성능 향상을 입증, 특히 자연어 추론, 질문 응답, 의미 유사성, 텍스트 분류 등에서 탁월한 결과를 보였는데 이와 같이, 본 연구는 사전학습과 미세조정을 결합한 접근법이 다양한 NLP 작업에서 우수한 성능을 달성할 수 있음을 보여주며, 지금까지 세상을 바꿔나가고 있다고 생각합니다.

'AI > Transformers 시리즈' 카테고리의 다른 글

| BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding (0) | 2025.01.31 |

|---|---|

| Attention Is All You Need : AI 혁명의 시작 (0) | 2025.01.20 |